目录

Resource Info Paper https://arxiv.org/abs/2502.12134 Code & Data https://github.com/xuyige/SoftCoT Public ACL Date 2025.07.04

Summary Overview

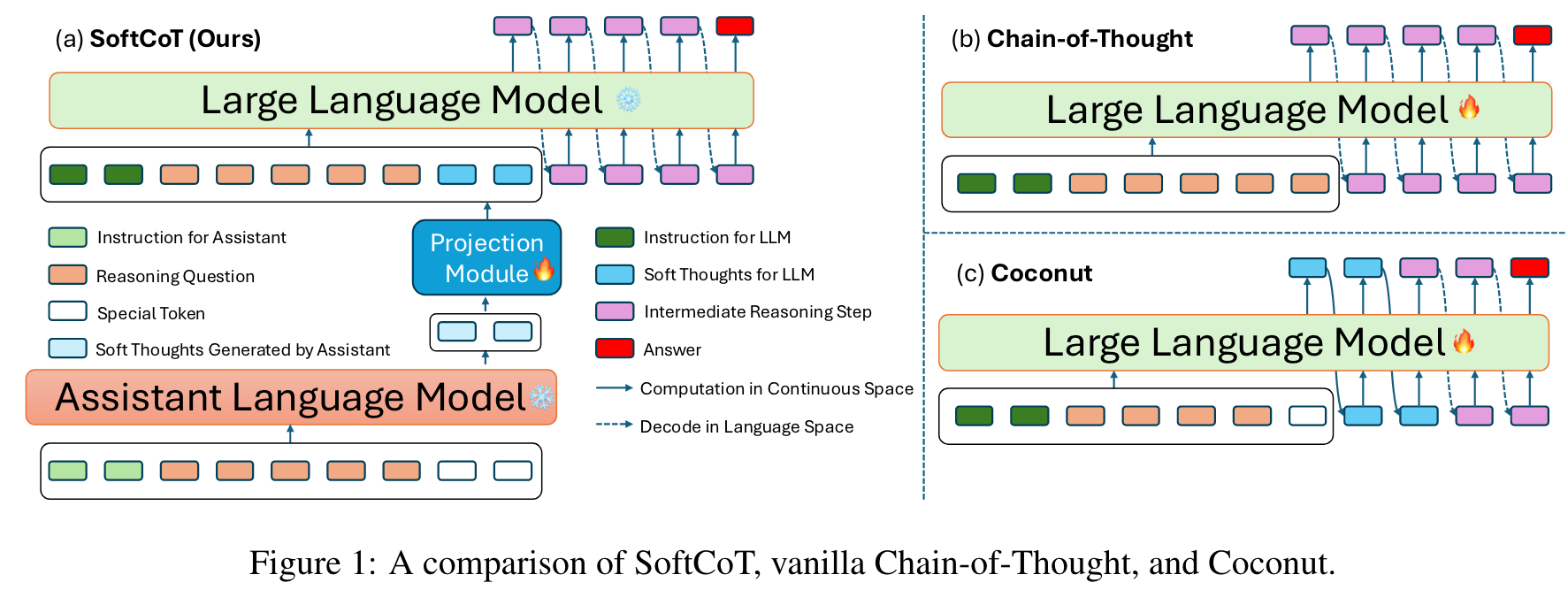

使用思维链能够使得 LLM 能够通过生成中间推理步骤来解决复杂的推理任务。但是,大多数现有方法都集中在 hard token 解码上,这会在离散词汇空间内限制推理。尽管最近一些工作探讨了连续的空间推理,但是这通常需要进行全量微调并且可能遇到灾难性遗忘。为了解决这个问题,作者提出了使用一个权重固定的轻量辅助模型来生成特定的 soft thought tokens,然后通过训练得到的投影模块将其映射到 LLM 的表示空间中。

Main Content

To facilitate reasoning in a continuous space, we use soft thought tokens (i.e., the last-layer hidden states from the small assistant model before mapping to the vocabulary space) instead of discrete tokens.

Given an input question , the framework produces a sequence of reasoning steps and the final answer .

SoftCoT consists of three key components: the soft thought token generation module, the projection module, and the CoT reasoning module.

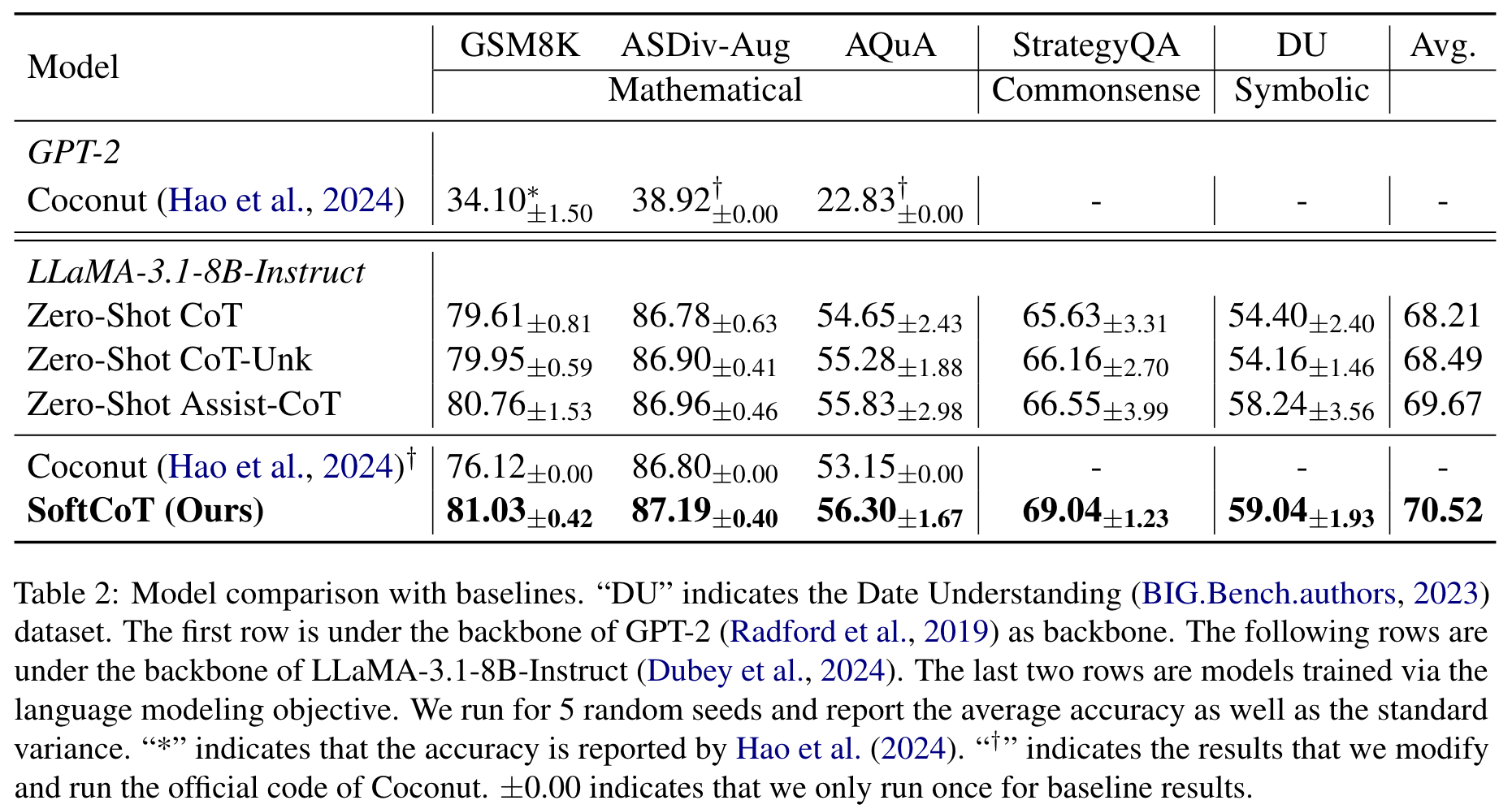

Coconut is not applicable to larger language models: We modify and run the official implementation of Coconut, adapting it to LLaMA-3.1-8B-Instruct. Our findings indicate that Coconut exhibits performance degradation following supervised fine-tuning with the language modeling objective, which can be attributed to the catastrophic forgetting phenomenon. This observation aligns with findings from prior studies.

🤖

-

论文的创新之处与独特性:

- 创新点:

- 提出了软链式思维(SoftCoT)框架,通过引入辅助模型生成连续空间中的软思维标记(soft thought tokens),克服了传统链式思维(CoT)依赖离散硬标记的局限性。

- 采用投影模块将辅助模型生成的软标记映射到主语言模型的表示空间,避免了对主语言模型进行全模型微调,从而减轻了灾难性遗忘问题。

- 通过参数高效的微调方法,仅优化投影模块参数,保持了主语言模型的预训练知识,同时提升了推理性能。

- 独特性:

- 在无需修改主语言模型的情况下,通过辅助模型生成任务特定的软标记,动态适应不同的推理任务,增强了泛化能力。

- 结合连续空间推理和链式思维的优势,减少了推理过程中冗余计算,提高了推理效率。

- 实验覆盖五个推理基准和两种主流语言模型架构,验证了方法的鲁棒性和适用性。

- 创新点:

-

论文中存在的问题及改进建议:

- 问题:

- 对更大规模模型的适用性缺乏验证:论文仅在约7-8B参数规模的语言模型上进行了实验,未验证SoftCoT在更大规模模型(如GPT-4或PaLM)的表现。

- 软标记生成的质量依赖辅助模型:辅助模型生成的软标记质量可能直接影响推理性能,论文未详细探讨如何优化辅助模型或提升软标记质量。

- 数据集覆盖范围有限:尽管论文涵盖了数学推理、常识推理和符号推理,但未涉及多模态推理任务(如视觉-语言结合)或更复杂的推理场景。

- 改进建议:

- 在更大规模的语言模型上进行实验,验证SoftCoT的可扩展性,并分析其在不同规模模型中的性能变化。

- 探索优化辅助模型的方法,例如通过多任务微调或知识蒸馏提升辅助模型生成软标记的质量。

- 扩展实验至多模态推理任务,验证SoftCoT在视觉-语言结合任务中的适用性,并开发适配多模态的投影模块。

- 问题:

-

基于论文的内容和研究结果,提出的创新点或研究路径:

- 创新点1:跨模态软链式思维(Multi-modal SoftCoT)

- 将SoftCoT扩展到多模态任务中,例如视觉-语言推理,通过引入视觉辅助模型生成视觉相关的软标记,并与语言模型的软标记结合。

- 创新点2:动态软标记生成(Dynamic Soft Token Generation)

- 开发一种动态生成软标记的方法,根据输入任务的复杂性和上下文动态调整软标记的数量和内容,以进一步提升推理效率。

- 创新点3:知识增强的软链式思维(Knowledge-enhanced SoftCoT)

- 集成外部知识库或知识图谱,通过辅助模型生成知识增强的软标记,提升模型在常识推理和领域特定任务中的表现。

- 创新点1:跨模态软链式思维(Multi-modal SoftCoT)

-

为新的研究路径制定的研究方案:

-

研究路径1:跨模态软链式思维(Multi-modal SoftCoT)

- 研究方法:

- 设计一个视觉辅助模型(如CLIP或BLIP),生成视觉相关的软标记。

- 开发一个多模态投影模块,将视觉软标记与语言软标记融合,并映射到主语言模型的表示空间。

- 在多模态推理数据集(如VQA或OKVQA)上进行实验,评估方法的性能。

- 研究步骤:

- 构建视觉辅助模型并生成视觉软标记。

- 设计多模态投影模块,融合视觉和语言软标记。

- 在多模态推理任务上进行训练和测试,比较与现有方法的性能。

- 期望成果:

- 提出一种适用于多模态任务的软链式思维框架,显著提升多模态推理性能。

- 验证视觉和语言软标记的协同作用,提高模型的推理效率和准确性。

- 研究方法:

-

研究路径2:动态软标记生成(Dynamic Soft Token Generation)

- 研究方法:

- 引入一个动态生成模块,根据输入任务的复杂性和上下文动态调整软标记的数量和内容。

- 优化生成模块的参数,使其能够根据任务需求生成最优的软标记。

- 研究步骤:

- 设计动态生成模块,结合任务特定信息生成软标记。

- 在多种推理任务上进行实验,分析动态生成模块的效果。

- 与固定数量软标记的方法进行比较,验证动态生成的优势。

- 期望成果:

- 提出一种更灵活的软链式思维生成方法,减少冗余计算,提高推理效率。

- 通过动态调整软标记数量,进一步提升模型在复杂任务中的表现。

- 研究方法:

-

研究路径3:知识增强的软链式思维(Knowledge-enhanced SoftCoT)

- 研究方法:

- 集成外部知识库或知识图谱,通过辅助模型生成知识增强的软标记。

- 优化投影模块,使其能够有效融合知识标记与语言模型的表示。

- 研究步骤:

- 构建知识增强的辅助模型,生成知识相关软标记。

- 设计知识融合投影模块,将知识标记与语言标记结合。

- 在常识推理和领域特定任务上进行实验,评估知识增强的效果。

- 期望成果:

- 提出一种结合外部知识的软链式思维框架,显著提升模型在常识推理和领域特定任务中的性能。

- 验证知识增强的软标记对复杂推理任务的帮助,提高模型的泛化能力。

- 研究方法:

-

Others

本文作者:Geaming

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!